1. Einführung

Zuletzt aktualisiert: 08.02.2022

Warum ist Multi-Cloud-Streaming erforderlich?

Unternehmen versuchen aktiv, ihre Arbeitslasten auf mehrere Cloud-Plattformen zu verteilen, da die Nutzung mehrerer Cloud-Anbieter in den betrieblichen Workflow eines Unternehmens mehrere Vorteile bietet:

- Anbieterabhängigkeit

- Risiko für die Geschäftskontinuität minimieren

- Abhängigkeiten und Abhängigkeit von einem Technologie-Stack

Umfang

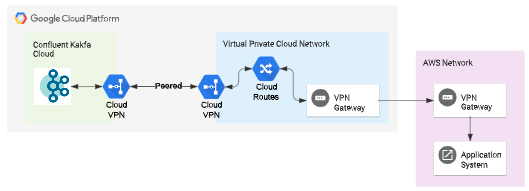

In diesem Codelab richten Sie ein Multi-Cloud-Data-Streaming zwischen AWS und GCP mit Confluent Cloud ein. Sie werden Folgendes tun:

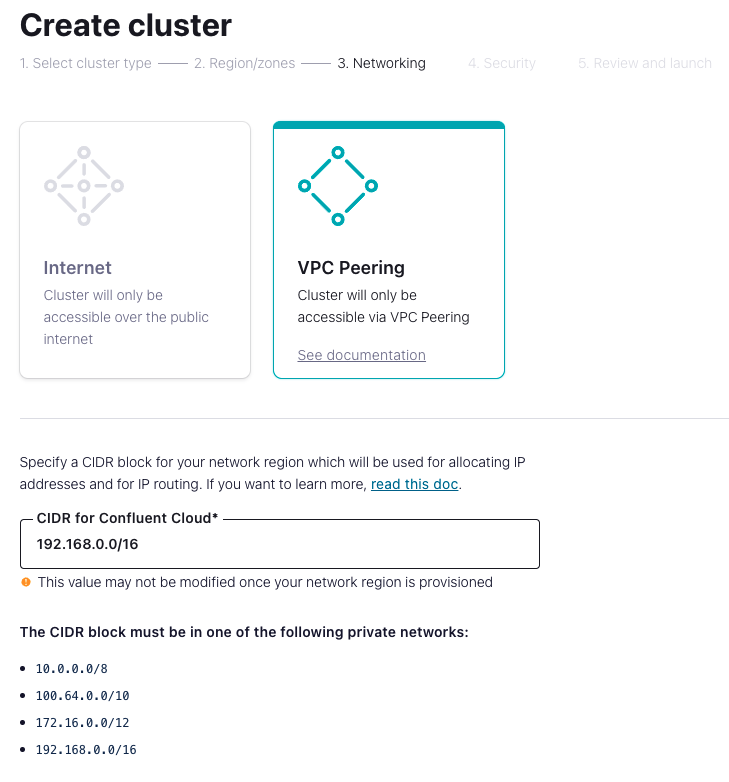

- Richten Sie einen dedizierten Kafka-Cluster in Confluent Cloud auf der GCP ein.

- Richten Sie ein VPC-Peering zwischen Confluent Cloud und Ihrem GCP-Projekt ein, damit darauf über ein privates Netzwerk zugegriffen werden kann.

- Richten Sie einen VPN-Tunnel zwischen Ihrem AWS-Projekt und Ihrem GCP-Projekt ein, damit die Ressourcen auf beiden Hyperscalern eine Verbindung herstellen können.

- Auf Confluent Kafka von AWS aus zugreifen und eine Streamingpipeline von AWS zu GCP einrichten, die Confluent Kafka Cloud nutzt.

Lerninhalte

- So richten Sie VPC-Peering zwischen Confluent Cloud Kafka und Ihrem GCP-Projekt ein.

- Einrichten eines VPN-Tunnels zwischen AWS- und GCP-Projekten

- So greifen Sie von Ihrem AWS-Projekt aus auf GCP-gehostete Confluent Cloud zu.

In diesem Codelab geht es um das Erstellen von Multi-Cloud-Datenstreaming. Auf irrelevante Konzepte wird nicht genauer eingegangen und entsprechende Codeblöcke können Sie einfach kopieren und einfügen.

Voraussetzungen

- AWS-Projektzugriff

- Zugriff auf GCP-Projekte.

- Erfahrung mit GCP und AWS Cloud.

- Confluent Kafka-Abo über GCP Marketplace

2. Einrichtung

VPN-Verbindung zwischen AWS und GCP einrichten

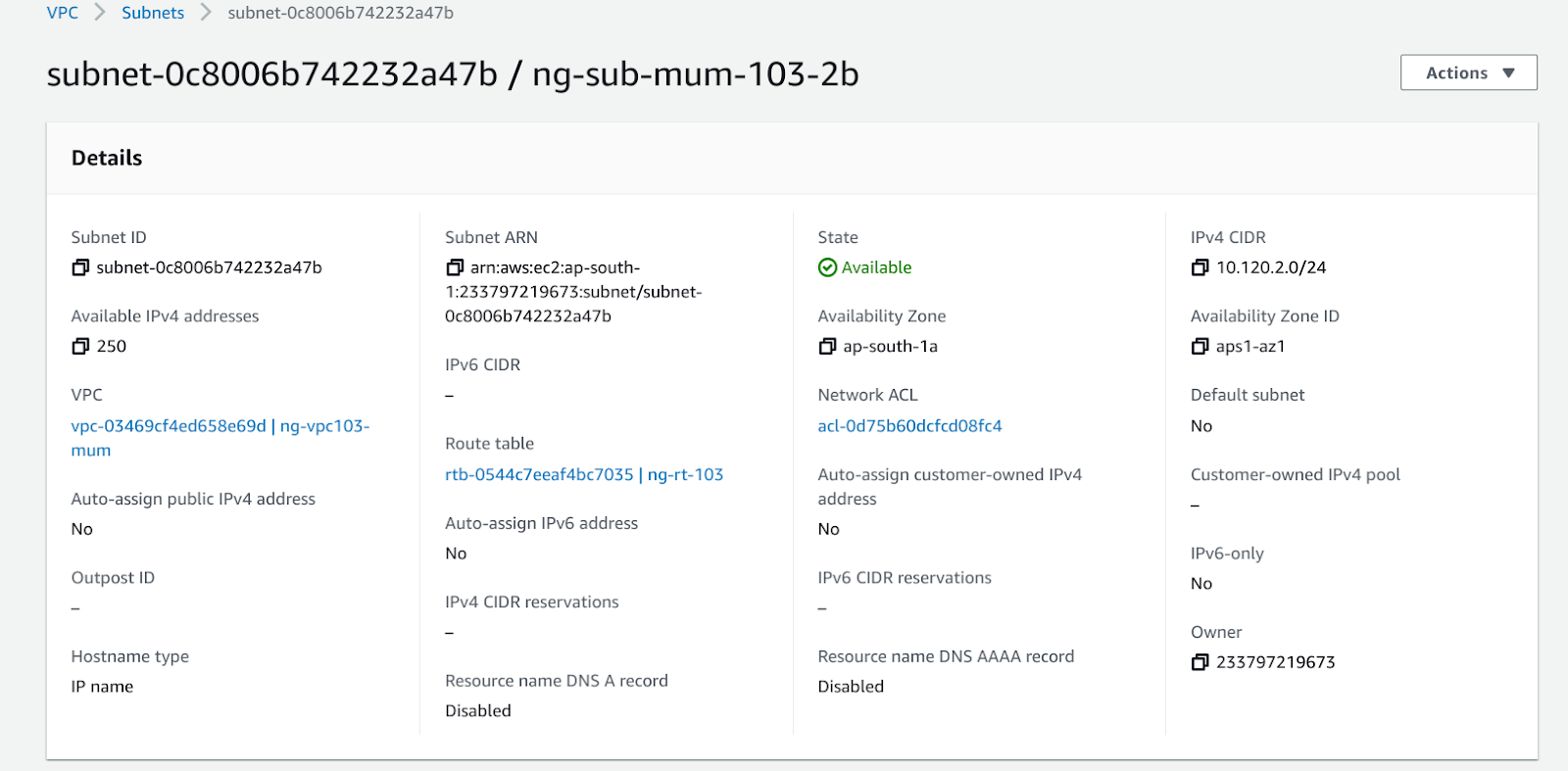

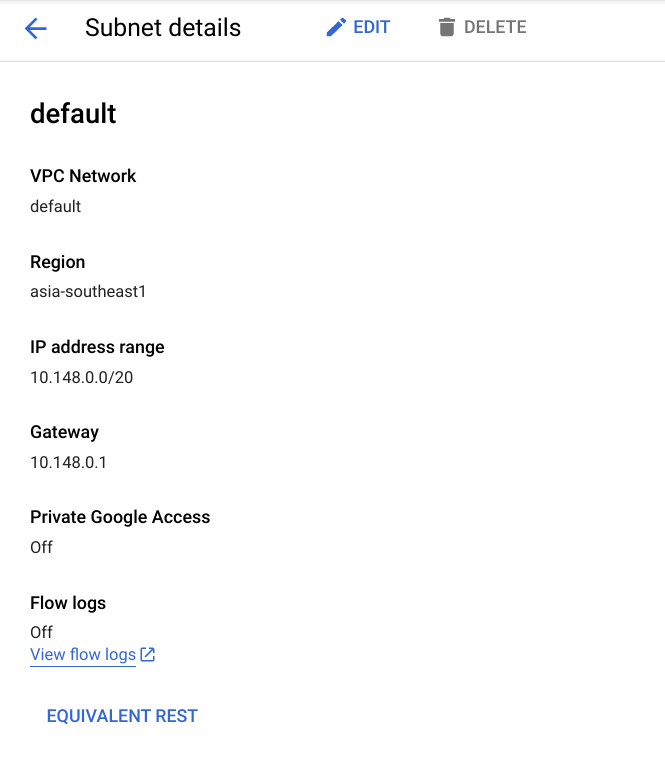

- In dieser Demo wird die Standard-VPC (asia-southeast1) in der GCP und ng-vpc-103-mum (ap-south1) in AWS verwendet.

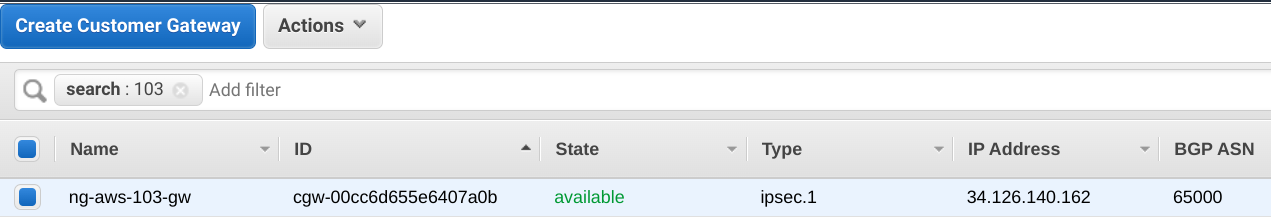

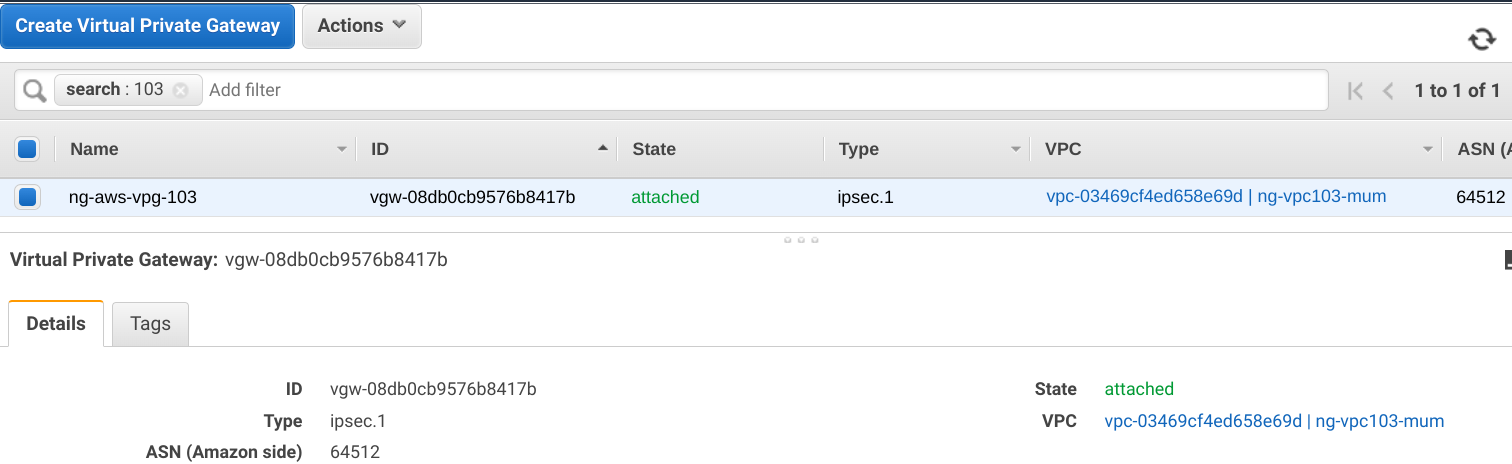

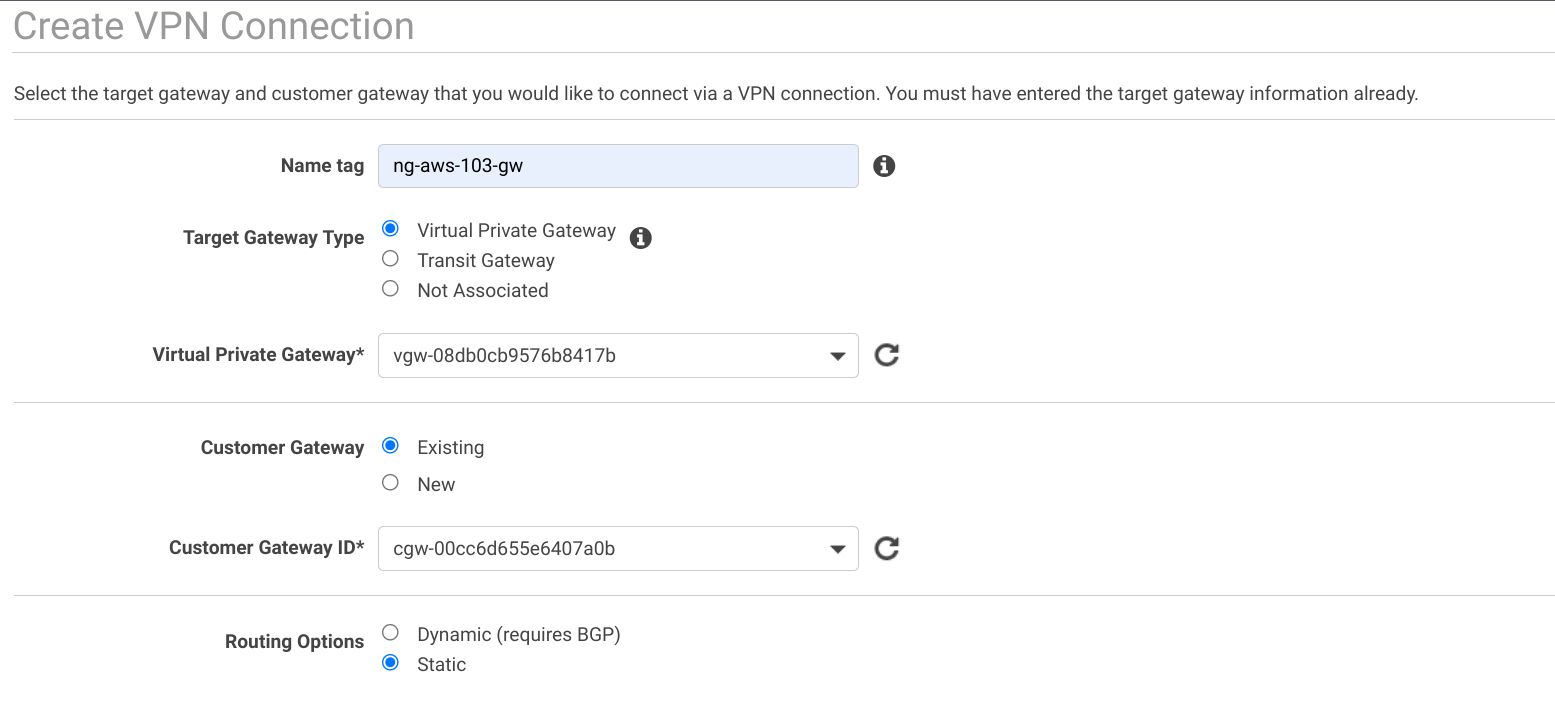

- Erstellen Sie auf AWS das Customer Gateway und das Virtual Private Gateway (VPG). Hängen Sie das VPG an die AWS-VPC an.

- Erstellen Sie die Site-to-Site-VPN-Verbindung in AWS.

- Laden Sie die Konfigurationsdatei für den in AWS erstellten Tunnel herunter. Auswählen

- Anbieter : Allgemein

- Plattform : Allgemein

- Software : Anbieterunabhängig

- IKE-Version : Ikev2

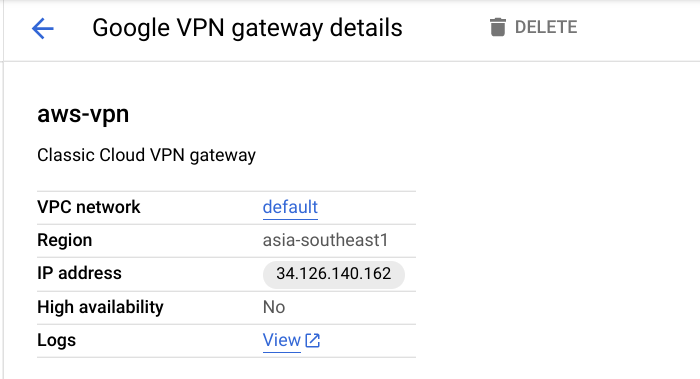

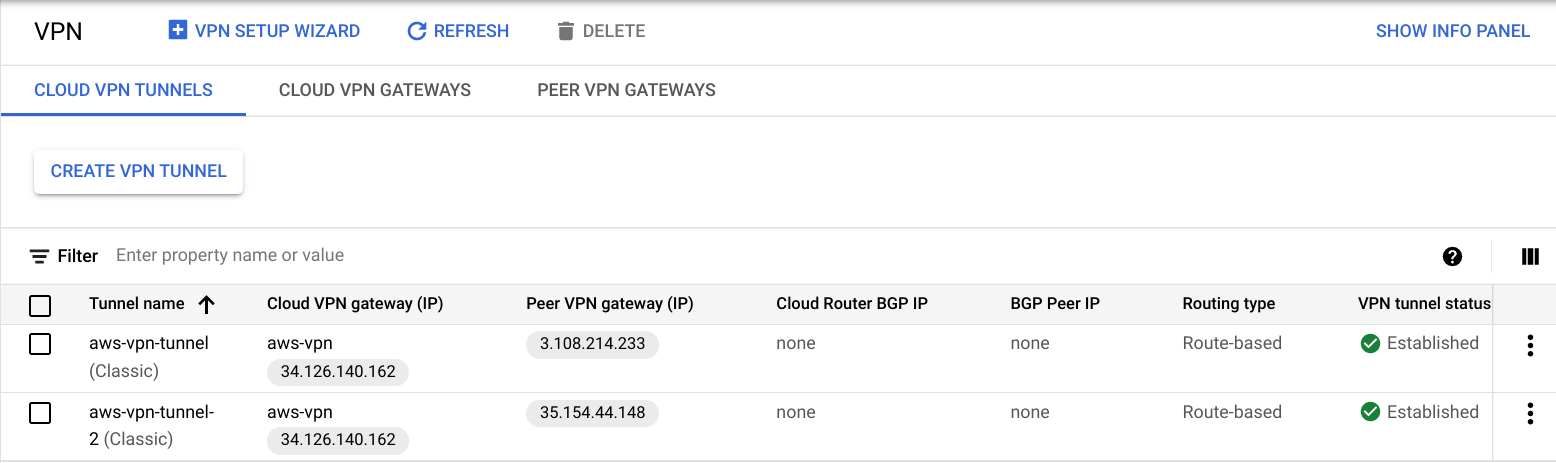

- Erstellen Sie das VPN-Gateway und den VPN-Tunnel in GCP.

Geben Sie die IP-Adresse und den IKEv2-Schlüssel aus der heruntergeladenen AWS-Konfigurationsdatei für beide Tunnel an.

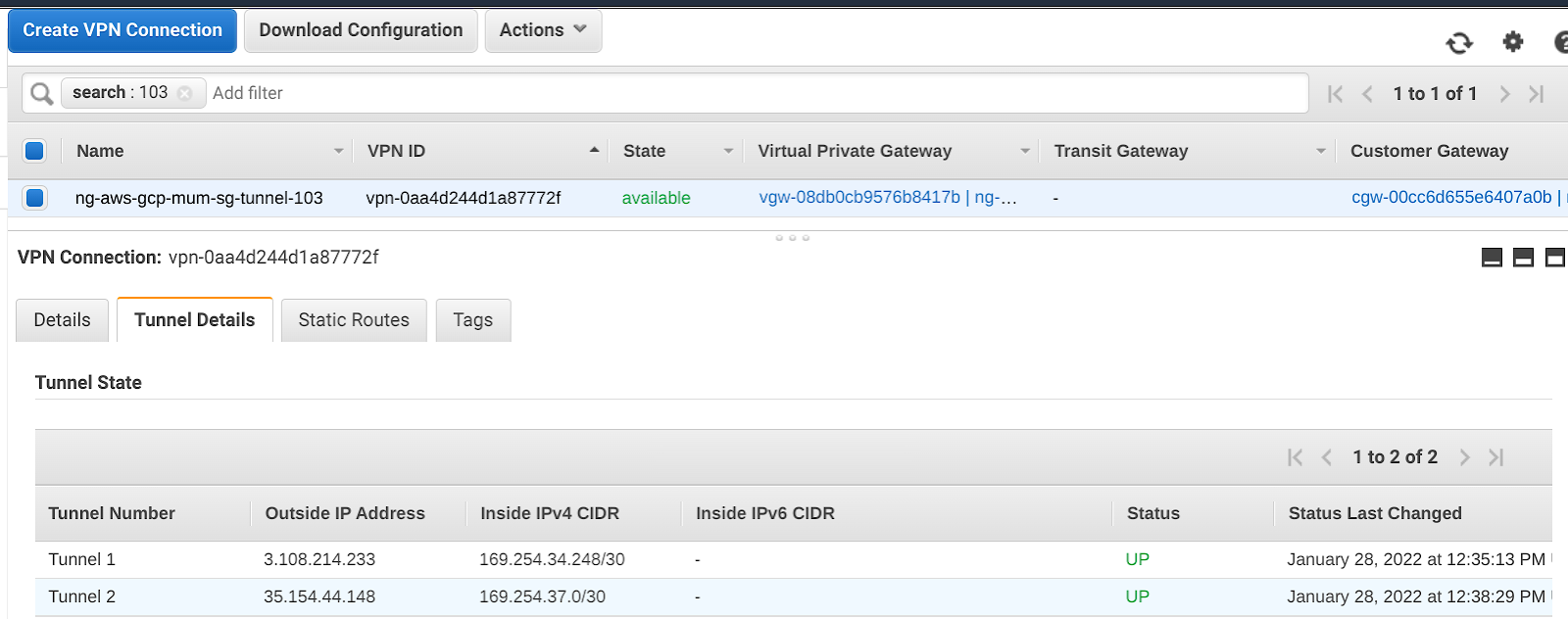

- Nach Abschluss sollte der Tunnel in AWS und GCP aktiv sein.

Die Einrichtung des Tunnels ist jetzt abgeschlossen.

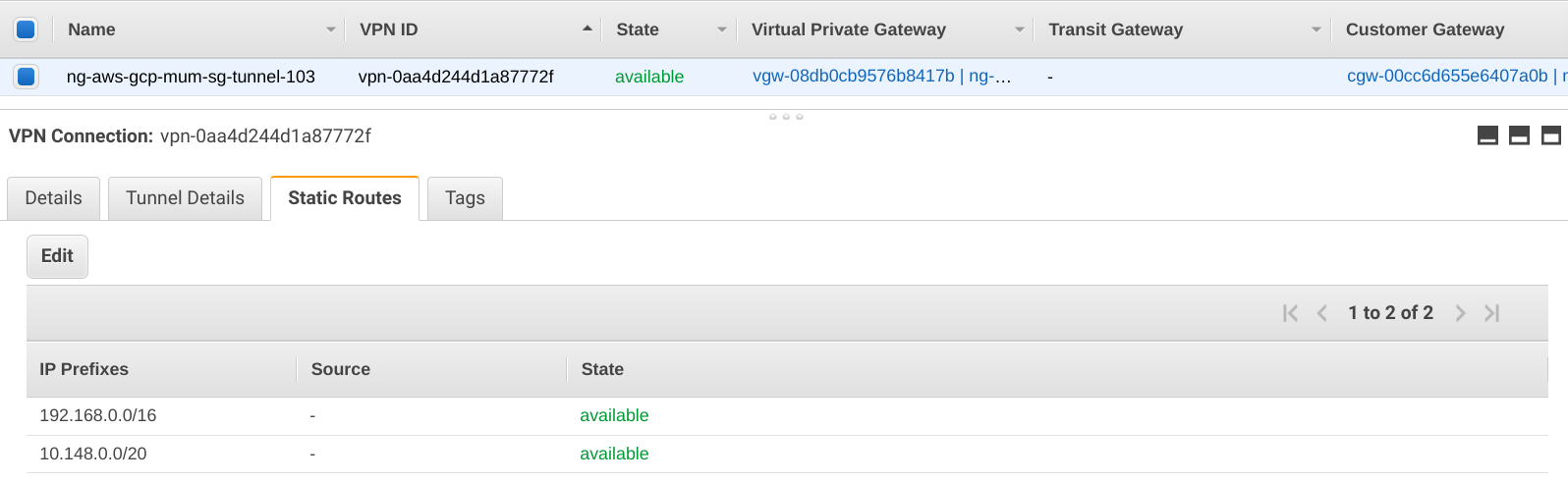

- Wählen Sie einen CIDR-Block aus, der zum Konfigurieren der Confluent Cloud verwendet wird. Fügen Sie dies dem VPN-Tunnel als statische Route in AWS hinzu.

Confluent Kafka auf dem GCP Marketplace

- Abonnieren Sie Confluent Kafka im GCP Marketplace.

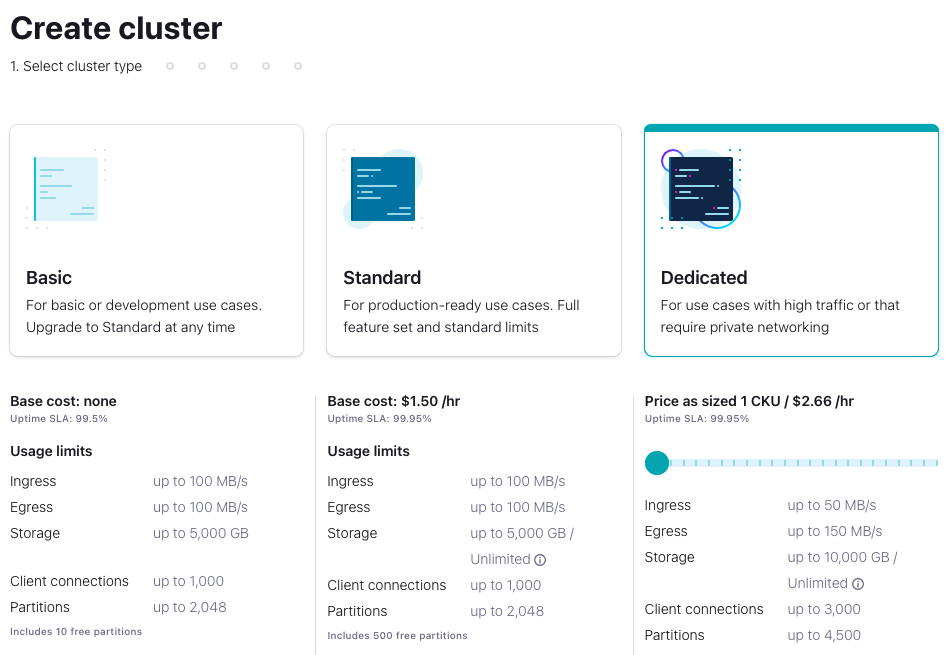

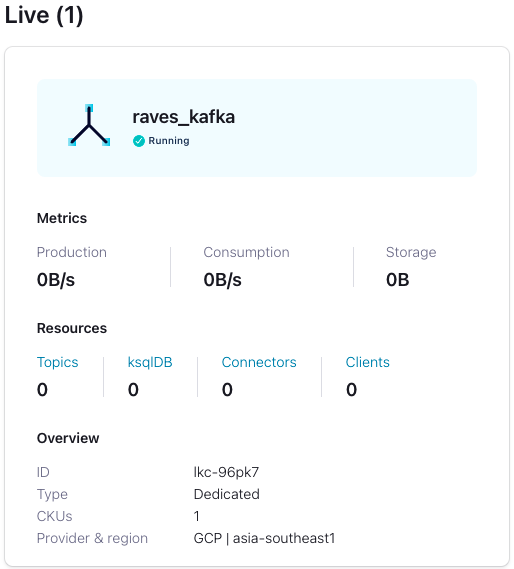

- Bei Confluent Cloud anmelden und einen Dedicated Cluster erstellen

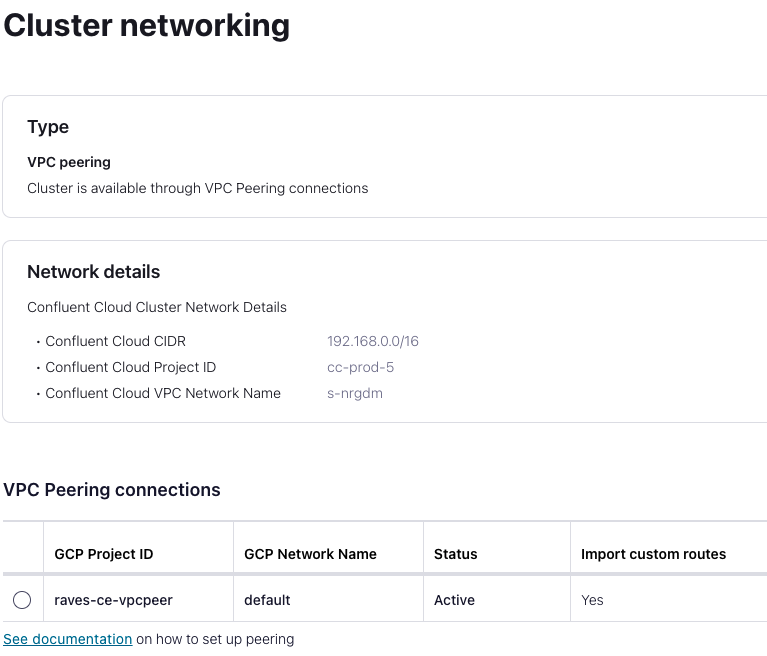

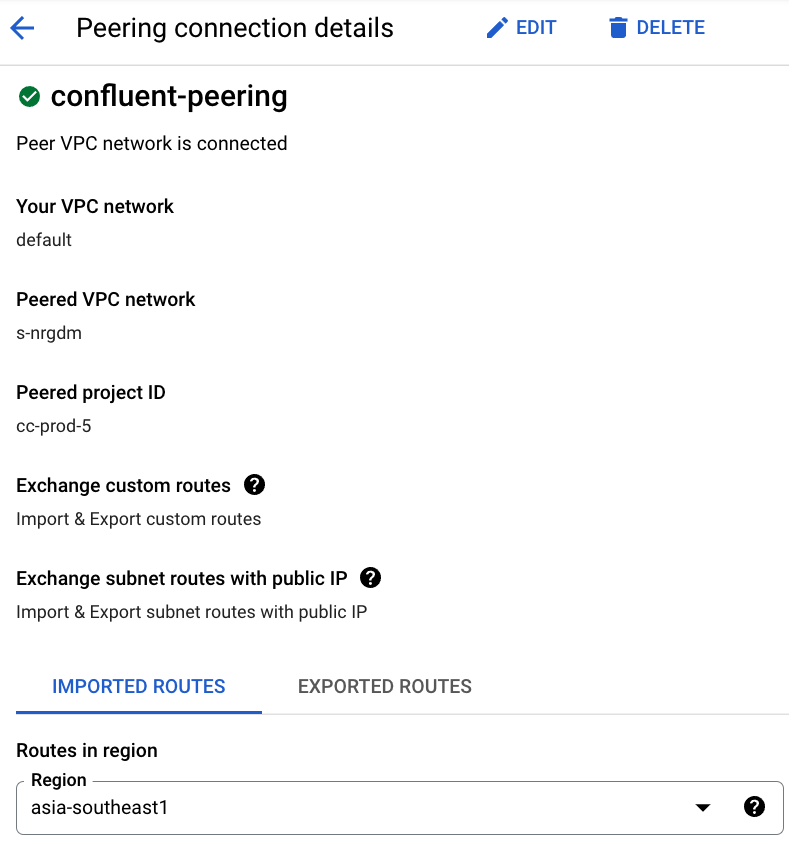

- Geben Sie die GCP-Projekt-ID zusammen mit den VPC-Netzwerkdetails für das Peering an.

- Schließen Sie das VPC-Peering auf GCP-Seite mit den bereitgestellten Confluent Cloud-Cluster-Netzwerkdetails ab.

- Der Confluent Cloud-Cluster ist jetzt aktiv und mit GCP verbunden.

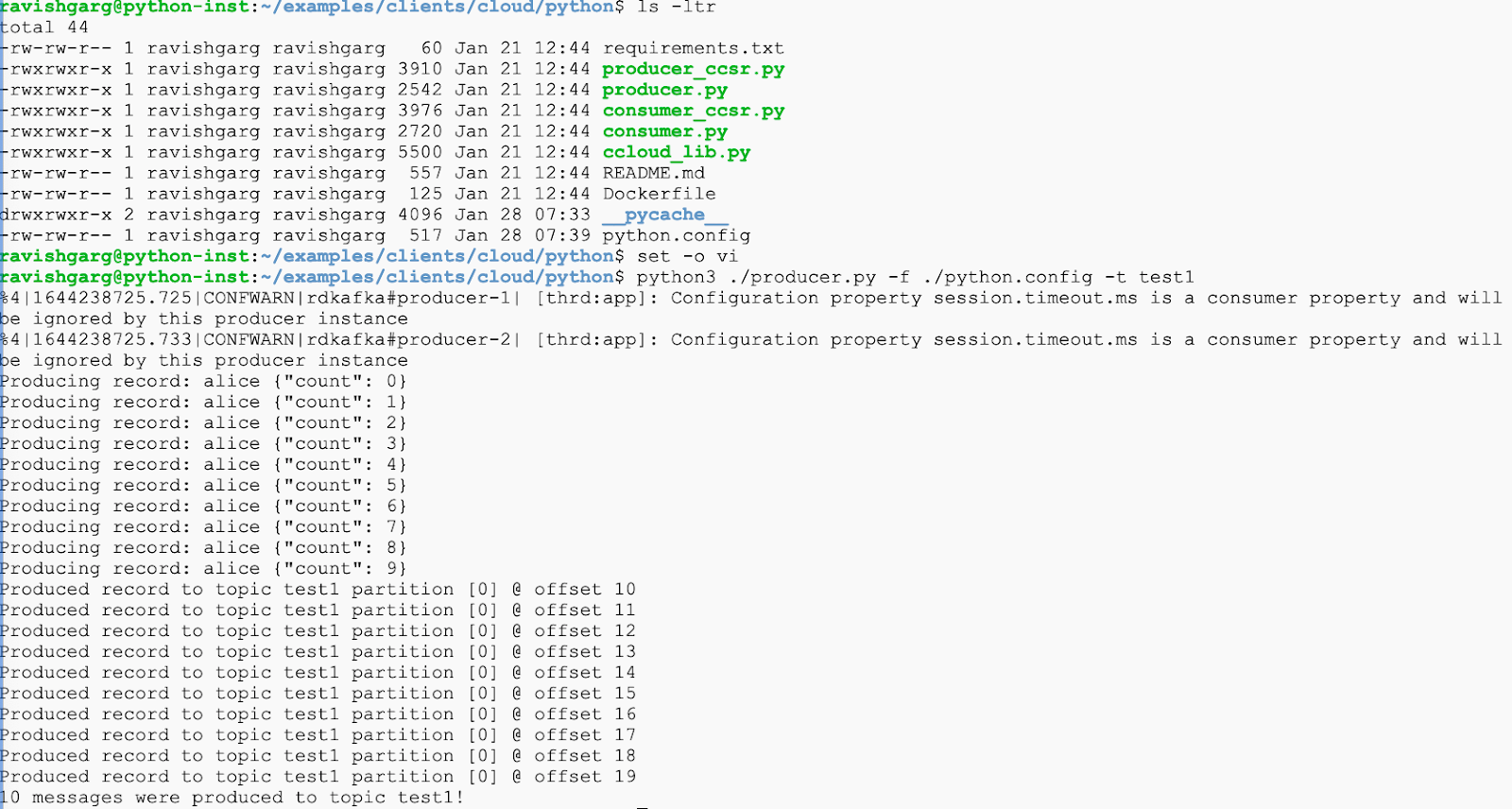

- Testen Sie die Verbindung zum Confluent-Cluster über GCP.

- GCE-Instanz bereitstellen und Python 3 installieren

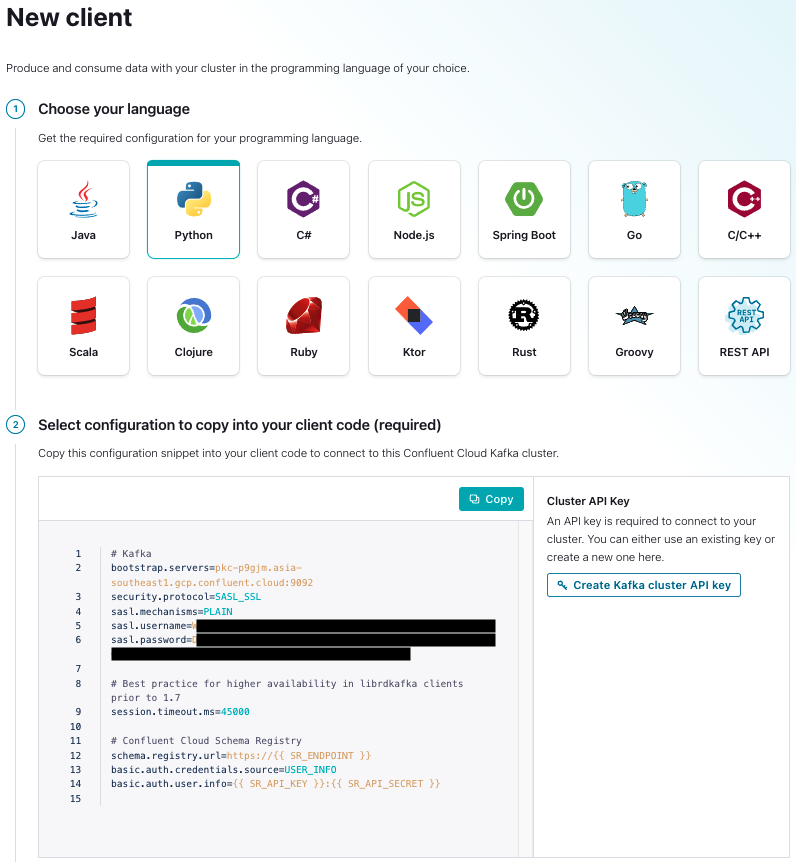

- Python-Clientschlüssel in Confluent Cloud generieren

- Führen Sie das Testskript „producer.py“ über die GCP-Instanz aus:

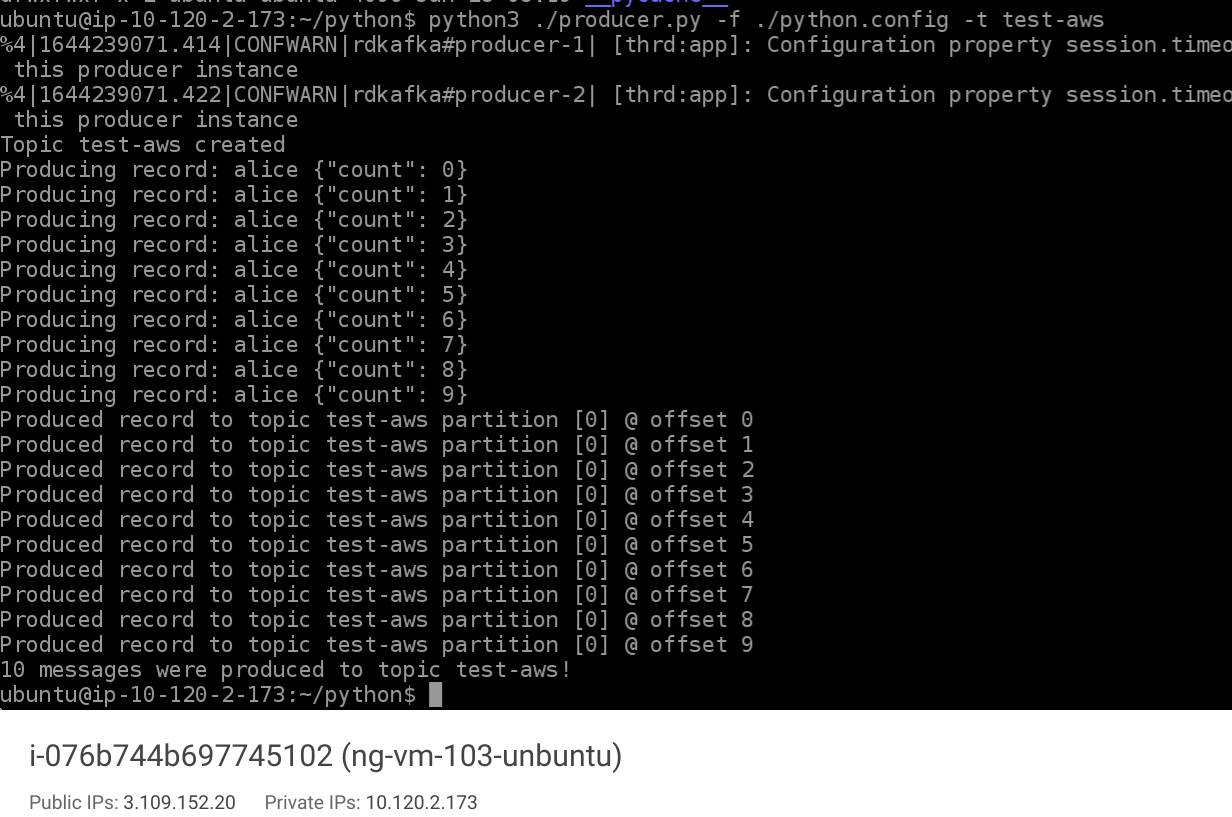

- Laden Sie nun den Beispielcode auf die AWS-Instanz herunter und führen Sie das Skript „producer.py“ aus, um die Hybridverbindung zu Confluent Cloud über GCP zu testen.

3. Glückwunsch

Sie haben Ihre regionenübergreifende Multi-Cloud-Streamingplattform für Confluent Kafka zwischen AWS und GCP erfolgreich erstellt.

Hilfreiche Codelabs**?**

Hier sind einige Codelabs: